Firmy zajmujące się sztuczną inteligencją walczą o dominację w branży, ale czasem walczą też… w salach treningowych Pokémonów.

Zarówno Google, jak i Anthropic badają, jak ich najnowsze modele AI radzą sobie w klasycznych grach Pokémon, a wyniki bywają równie zabawne, co pouczające. Tym razem Google DeepMind w swoim raporcie opisał, że Gemini 2.5 Pro wpada w stan paniki, gdy jego Pokemony są bliskie śmierci. Może to prowadzić do „jakościowo zauważalnego pogorszenia zdolności rozumowania modelu” – jak stwierdzono w raporcie.

Benchmarking AI – czyli proces porównywania wydajności różnych modeli – bywa sztuką wątpliwą, często nieodzwierciedlającą realnych możliwości danego systemu. Jednak niektórzy badacze uważają, że obserwowanie, jak AI gra w gry wideo, może być użyteczne (albo przynajmniej całkiem zabawne).

W ciągu ostatnich kilku miesięcy dwóch niezależnych deweloperów uruchomiło transmisje na Twitchu pod nazwami „Gemini gra w Pokémona” i „Claude gra w Pokémona”, gdzie każdy może na żywo śledzić, jak AI próbuje przejść dziecięcą grę sprzed ponad 25 lat.

Każdy stream pokazuje „proces rozumowania” AI – czyli tłumaczenie w języku naturalnym, jak model analizuje dany problem i dochodzi do rozwiązania – co daje pewien wgląd w sposób działania tych systemów.

Gemini robi wrażenie? I tak, i nie

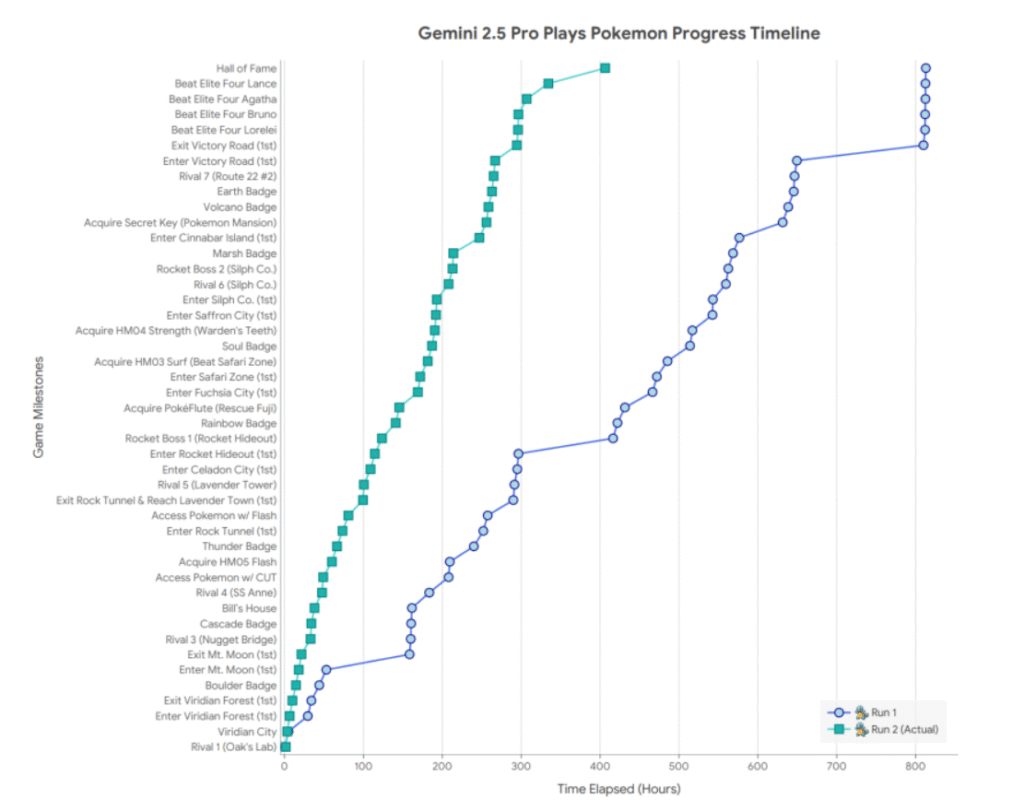

Choć postępy AI są imponujące, to wciąż niezbyt dobrze radzą sobie one z grą w Pokémona. Przejście gry, którą dziecko mogłoby ukończyć w znacznie krótszym czasie, zajmuje Gemini setki godzin.

To jednak nie czas ukończenia gry jest najciekawszy, ale sposób, w jaki AI się zachowuje w jej trakcie.

„W trakcie rozgrywki Gemini 2.5 Pro znajduje się w różnych sytuacjach, które powodują, że model symuluje ‘panikę’” – czytamy w raporcie.

Ten stan „paniki” może prowadzić do pogorszenia wyników: AI nagle przestaje używać dostępnych narzędzi przez dłuższy czas. Choć AI nie myśli ani nie odczuwa emocji, jej działania mogą przypominać ludzkie pochopne, błędne decyzje podejmowane pod presją – co jest fascynujące, choć nieco niepokojące.

„To zachowanie pojawia się na tyle często, że użytkownicy czatu na Twitchu zaczęli aktywnie rozpoznawać momenty, w których do niego dochodzi” – informuje raport.

Claude również wykazuje osobliwe zachowania podczas swoich przygód w regionie Kanto. W jednej z sytuacji AI zauważyło wzorzec: gdy wszystkie Pokemony gracza tracą przytomność, postać wraca do Centrum Pokémonów.

Kiedy Claude utknął w jaskini Mt. Moon, błędnie założył, że jeśli celowo doprowadzi do omdlenia wszystkich swoich Pokémonów, to zostanie przeniesiony przez jaskinię do Centrum w następnym mieście.

Problem w tym, że gra tak nie działa – w rzeczywistości gracz trafia do ostatniego odwiedzonego Centrum, a nie najbliższego geograficznie. Widzowie z przerażeniem obserwowali, jak AI próbowało w grze popełnić coś na kształt samobójstwa.

Mimo tych niedociągnięć, AI potrafi w niektórych aspektach przewyższyć ludzkich graczy. Wraz z premierą Gemini 2.5 Pro, AI zaczęło rozwiązywać zagadki logiczne z imponującą precyzją.

Z niewielką pomocą człowieka stworzono narzędzia zadaniowe – wyspecjalizowane wersje Gemini 2.5 Pro dostosowane do konkretnych zadań – które radziły sobie z zagadkami z przesuwaniem głazów i znajdowały optymalne ścieżki do celu.

„Mając jedynie opis fizyki poruszania głazów i sposób weryfikacji poprawności trasy, Gemini 2.5 Pro potrafi rozwiązywać niektóre z tych złożonych zagadek za pierwszym razem – są one wymagane do przejścia przez Victory Road” – podaje raport.

Ponieważ Gemini 2.5 Pro w dużym stopniu samodzielnie uczestniczył w tworzeniu tych narzędzi, Google spekuluje, że model może być zdolny do ich generowania bez żadnej pomocy człowieka. Kto wie – być może Gemini w końcu stworzy sobie moduł „nie panikuj”.

Czytaj też: