Czołowi gracze chcą przyspieszyć wdrażanie sztucznej inteligencji przez firmy, oferując portfolio rozwiązań do budowy i rozwijania modeli AI w środowisku prywatnym.

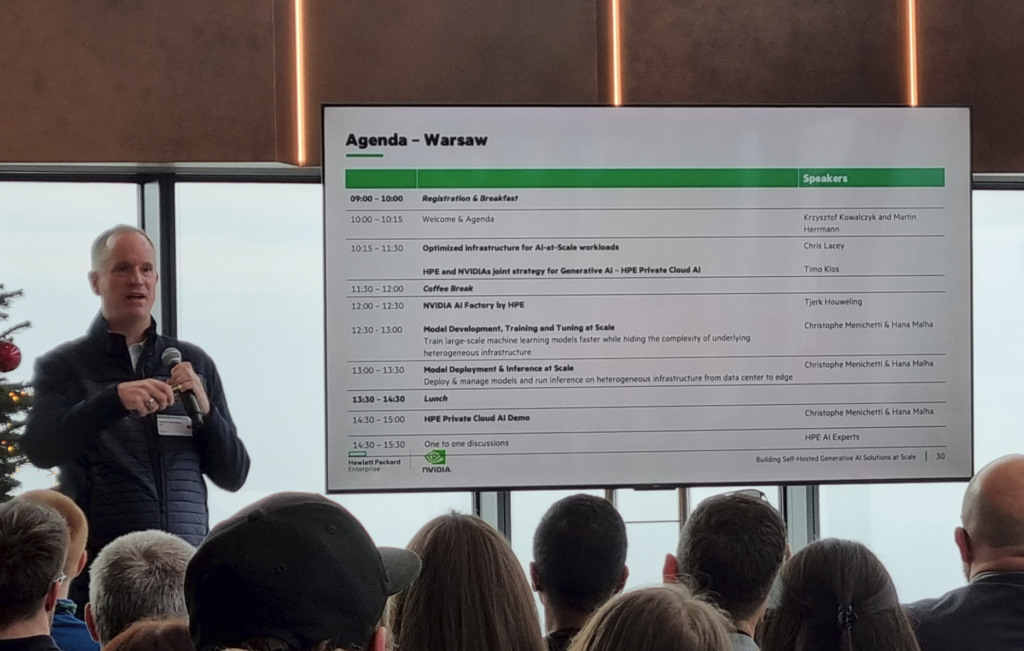

Seria wydarzeń „Building Self-Hosted Generative AI Solutions at Scale” organizowanych przez HPE wraz z NVIDIA, którego edycje odbyły się już m.in. Londynie, Amsterdamie, Frankfurcie i Monachium, dotarł do Warszawy. To element przekonywania środowiska profesjonalistów AI do wspólnej oferty obu potentatów: kompleksowego rozwiązania do obsługi AI w prywatnej chmurze.

Synergia potentatów ma urzeczywistnić rewolucję GenAI

Hewlett Packard Enterprise (HPE) oraz NVIDIA odgrywają dziś kluczową rolę w rewolucji adaptacji sztucznej inteligencji (AI) przez firmy na całym świecie.

HPE dostarcza systemy superkomputerowe i rozwiązania chmury prywatnej, takie jak HPE Private Cloud AI, które integrują rozwiązania AI z infrastrukturą chmurową i obliczeniową. Istotą tych rozwiązań jest przyspieszenie procesu trenowania modeli AI i uzyskiwanie wartości z tych technologii. Spełnia to zarazem potrzebę tworzenia i wykorzystywania dużych modeli językowych AI w środowiskach prywatnych, gdzie przetwarzanie danych będzie zgodne z regulacjami ochrony danych, a zarazem efektywniejsze finansowo niż w chmurach publicznych.

NVIDIA dostarcza potężne procesory graficzne i oprogramowanie, które zdominowały dziś rynek rozwiązań pozwalających uzyskać wydajność obliczeniową niezbędną do przetwarzania zadań związanych z AI. Zapewnia także rozwijany stale ekosystem adaptacji, obsługi i rozwijania rozwiązań AI na bazie swojej platformy sprzętowej.

W czerwcu br. podczas konferencji HPE Discover, obie firmy ogłosiły rozszerzone partnerstwo. Współpraca posłużyła do stworzenia kompleksowego portfolio rozwiązań „NVIDIA AI Computing by HPE”, których zadaniem jest ułatwienie wdrażania generatywnej sztucznej inteligencji w środowiskach biznesowych.

NVIDIA AI Computing by HPE jako zawiera w sobie rozwiązanie HPE Private Cloud AI. Integruje ono narzędzia AI, oprogramowanie i rozwiązania sieciowe NVIDIA z rozwiązaniami pamięci masowej, obliczeniowymi i chmurowymi HPE GreenLake. Oczywisty pomysł potentatów na wspólne utwardzenie swojej pozycji na gorącym rynku AI posiada wszelkie predyspozycje aby odnieść sukces.

Na ból głowy firmowego specjalisty AI

Jednym z warunków powodzenia jest przekonanie środowiska praktyków, żyjących pod presją dostarczenia w swoich firmach środowiska do wydajnego eksperymentowania ze sztuczną inteligencją. Wydarzenia w ramach roadshow sprofilowane są wobec tego pod kątem potrzeb, wiedzy i zainteresowań data officers, inżynierów ds. uczenia maszynowego, data scientists – badaczy danych.

W scenariuszu warszawskiej warsztato-konferencji przeplatały się wystąpienia wyjaśniające konstrukcję i współdziałanie komponentów wspólnej oferty oraz dema budowy skalowalnego środowiska dla modelu generatywnej sztucznej inteligencji.

W ich trakcie przedstawiono zasady i dobre praktyki tworzenia środowiska dla uczenia maszynowego oraz skalowania treningu modeli LLM w celu wytwarzania na tej bazie aplikacji GenAI. Dokładnie przedstawiono także zalety oraz sposób zastosowania NIMS – NVIDIA Inferencing Microservices. To zestaw mikrousług wnioskowania, opartych na prekonfigurowanych do różnych kategorii zastosowań, np. dziedzinowych, modeli dostarczanych jako kontenery do integracji w środowisku klienta, pozwalających na szybkie stworzenie aplikacji AI. Są one dzięki integracji ze środowiskiem prywatnej chmury HPE istotnym elementem wspólnej oferty obu firm.

Z perspektywy data scientist, istotnym wyzwaniem jest zapewnienie schematu dostarczania danych z wielu organizacyjnych silosów. Niezbędna jest synchronizacja tego procesu, aby zapewnić odtwarzalność danych i linii eksperymentów.

Dla firm w trakcie procesu adaptacji AI kluczowe znaczenie ma oczywiście perspektywa kosztowa. Ważne jest stworzenie alternatywy modelu adaptacji AI – w postaci scenariusza adaptacji do lokalnego środowiska, które w odróżnieniu od chmury publicznej, można lepiej kontrolować pod kątem kosztów wykorzystywania powstających rozwiązań AI.

Kamienne tablice projektów AI

Eksperci HPE i NVIDIA proponują schemat postępowania, w zasadzie dobrych praktyk, które można też dopasowywać do indywidualnych sytuacji w firmie. Można mówić o wspólnym podejściu, które zawiera kilka spójnych perspektyw, np. perspektywę zapewnienia skalowalnego środowiska do rozwoju modelu językowego.

Aby skalować wdrożenie naszego modelu językowego, należy najpierw upewnić się, że rozumiemy, co jest wymagane, jaki jest przypadek użycia, rozmiar danych wsadowych, oczekiwany rozmiar danych wyjściowych, wiemy czy docelowy model plasuje się w kategorii małych, średnich czy dużych. To podstawa konieczna do zdefiniowania minimalnej infrastruktury.

Następnym krokiem jest zapewnienie narzędzia do automatycznego skalowania, które pomoże mierzyć wydajność wdrożonego rozwiązania. Jeśli liczba zapytań jest zbyt mała, można ograniczyć zarezerwowane zasoby do przetwarzania. Jeśli ilość zapytań przekracza możliwości skalowania, trzeba zreplikować model i przekazywać nadmiarowe zapytania do jego kopii. Kiedy pik minie, można powstały system ponownie skalować w dół.

Podobnych sztuczek ze skalowaniem można dokonywać jeszcze w innych sytuacjach. Trzeba jednak działać w ramach reguł. I tu pojawia się konieczność określenia, na kim spoczywa odpowiedzialność za ustanowienie i egzekwowanie tej metodyki. Powinna być to dyskusja z udziałem badacza danych, informatyka, ale i użytkownika z działu biznesowego.

Ludzie biznesu muszą powiedzieć, czego oczekują od danej aplikacji. Inżynier uczenia maszynowego, ulokowany pomiędzy IT a ludźmi biznesu, powinien przełożyć to na metryki i elementy zrozumiałe dla maszyny. Jest to wspólna praca inżyniera uczenia maszynowego i informatyków.

Osoba z działu IT zapewni dostęp do zasobów, udostępnia narzędzia do planowania itp. Inżynier uczenia maszynowego wdroży rozwiązanie uczenia maszynowego. Ale tylko dyskusja pomiędzy tymi trzema warstwami, pozwoli upewnić się, że potrzeby biznesowe są odpowiednio przekładane na potrzeby IT.

Po pewnym czasie korzystania z danego modelu, może się też okazać, że niektóre założenia zmieniają się z biznesowego punktu widzenia. Istnieją sposoby, aby model, który np. nie jest wystarczająco dobry, można przetworzyć do innej wersji i następnie migrować do niej dane i procesy. Ta migracja jest możliwa w płynny stopniowy sposób, aż do uzyskania docelowej, bardziej efektywnej wersji modelu. Elementem nieodzownym jest posiadanie narzędzi do mierzenia efektywności modeli w czasie. Takie podejście nie jest jeszcze jednak upowszechnione.

Podróż z AI

Niektóre firmy są już w stanie budować wszystko samodzielnie, inne jedynie w części polegają na rozwiązaniach innych firm, a wiele buduje dopiero tę wiedzę i możliwości np. w toku współpracy z HPE i NVIDIA. Jak podkreślali wszyscy prelegenci, jesteśmy jeszcze w bardzo wczesnej fazie rozwoju rynku.

Jeśli podróż firmy z AI podzielić można w uproszczeniu na cztery etapy: wstępny, eksperymentalny, rozwojowy i wreszcie – produkcyjny, to w ocenie ekspertów HPE i NVIDIA większość firm plasuje się w pierwszej grupie (63%), a w pozostałych kategoriach odpowiednio 13%, 12% i 12%.

We wstępnym etapie odbywa się poszukiwanie sposobów użycia i identyfikacja szans biznesowych, ale też gromadzenie pod tym kątem danych i ludzi. Po zdefiniowaniu sposobu użycia, następują przygotowania do PoC, a równolegle rozbudowuje się kompetencje, zespół oraz infrastrukturę i stawia kolejne piloty AI.

W trzecim etapie, po sukcesie PoC, przychodzi pora na skalowanie wykorzystania modelu. Na miejscu powinien być już lokalny zespół badaczy i specjalistów od AI. Jednocześnie biznes powinien zostać namaszczony do roli kierującego rozwojem wykorzystania rozwiązań w oparciu o swoje potrzeby. Firmy na tym etapie przygody z AI dysponują już dostępnym, odpowiednim budżetem na obszar AI.

W fazie produkcyjnego wykorzystania AI są firmy, które na co dzień do różnych modeli AI kierują strumienie pracy do przetworzenia, świadomość znaczenia AI jest w DNA organizacji i każdy posiada kompetencje do podejmowania decyzji, które wypracowane zostały przy wsparciu AI.

Wiele odmian wyzwań

W ocenie prelegentów, wyzwania stojące przed firmami są różnorodne. Co więcej, nie ma też zwykle jednej odpowiedzi nawet na podobne wyzwania. Kluczowym wyzwaniem, z którymi musi się zmierzyć większość firm próbujących wdrożyć sztuczną inteligencję, bywa zdefiniowanie przypadku użycia. Jest wiele firmy, które wiedzą, że mają dużo danych i zarazem nie wiedzą, co z nimi zrobić. Żeby wpaść na dobry pomysł potrzebują poświęcić na to odpowiednio dużo czasu.

Punktem wyjścia musi być zrozumienie, jaki problem biznesowy próbują rozwiązać. Okaże się wówczas często, że problem biznesowy będzie wykorzystywał 1% firmowych danych. Wówczas warto ośmielić się do zdefiniowania mapy drogowej przypadków użycia, nad którymi zespół AI i firma będą dalej pracować i nadać im priorytety.

Wyzwaniem i ograniczeniem są zasoby wiedzy specjalistycznej. W wielu firmach nie ma nikogo kto rozumie AI, w innych wiedza zamknięta jest do grona członków małych zespołów. Jeśli firmy są w trakcie kompletowania albo rozbudowy tych zespołów, to na pewno trudno im równocześnie uruchamiać projekty. Niestety wiadomo, że takie działania nie przebiegają szybko. Budowa zespołów nie dokonuje się z dnia na dzień.

Są też firmy, które zbudowały już wiedzę, ale trapią je wyzwania techniczne, które trudno rozwiązać po prostu pobierając dowolny model i uruchamiając go. Potrzebują wówczas na przykład dostrojenia, być może konkretnego sposobu na wykorzystanie RAG (Retrieved Augmented Generation), do udoskonalenia swoich modeli.

Wyzwania we wdrażaniu AI mają wiele odmian, związane są z pieniędzmi, umiejętnościami, zasobami, sprzętem i mocą. Eksperci HPE i NVIDIA przekonywali na konferencji, że całkowitą albo częściową odpowiedzią będzie w wielu przypadkach współpraca w oferowanym przez obie firmy środowisku. Ułatwieniem jest korzystanie z wielu prekonfigurowanych usług i konfiguracji, dostosowanych także pod kątem możliwości finansowych i zdefiniowanych potrzeb. Prognozując szybki wzrost adaptacji przez rynek GenAI zastrzegają, że w otoczeniu biznesowym będzie on możliwy przede wszystkim za sprawą modelu prywatnego AI, dostępnego najszybciej, najefektywniej i najbezpieczniej w postaci gotowych platform czy portfolio zintegrowanych rozwiązań, jak NVIDIA AI Computing by HPE.