Generuj wysokiej rozdzielczości wideo z tekstu i obrazów – oto nowa obietnica Stable Video Diffusion. Obecnie, niestety, ograniczona tylko dla badaczy (nie na użytek komercyjny).

Twórca Stable Diffusion, Stability AI, zaprezentował swój pierwszy model generowania wideo oparty na popularnym systemie tekst-na-obraz.

Firma ujawniła Video Diffusion, generatywny model AI wideo, który może tworzyć wideo z podpowiedzi tekstowych.

Wystarczy wpisać np. “rakieta startująca na pustyni” lub “fale rozbijające się o brzeg”, a Video Diffusion stworzy pożądany wynik w postaci filmu.

Model ten może również generować wideo ze zdjęć. Zgodnie z dokumentem Stable Video Diffusion, zespół stojący za nim zaprojektował rozwiązanie w taki sposób, aby zapewnić wysokiej rozdzielczości modelowanie obraz-na-wideo.

Jak uzyskać dostęp do Stable Video Diffusion

Model jest przeznaczony do zadań takich jak wielopunktowa synteza z pojedynczego obrazu – animatorzy mogą go używać do generowania różnych kątów kamery obiektu lub pomocy w tworzeniu środowisk 3D dla doświadczeń VR i AR.

Dalsza część pod materiałem wideo:

Model jest obecnie ograniczony wyłącznie do badań. Wpis na blogu Stability stwierdza, że model “nie jest przeznaczony do zastosowań w rzeczywistym świecie lub komercyjnych na tym etapie”.

Zamiast tego, twórca narzędzia szuka na razie opinii na temat bezpieczeństwa i jakości, aby dopracować model do ostatecznego wydania.

Badacze mogą uzyskać dostęp do kodu dla Video Diffusion za pośrednictwem GitHub. Wagi potrzebne do lokalnego uruchomienia modelu można znaleźć na Hugging Face.

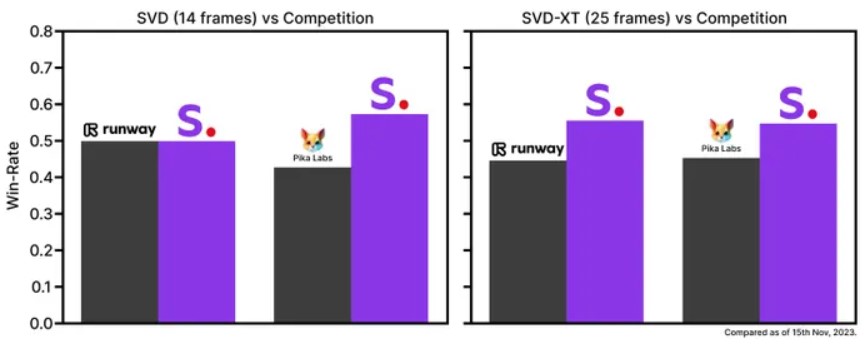

Stable Video Diffusion jest dostępny za pośrednictwem dwóch modeli obraz-na-wideo, zdolnych do generowania 14 i 25 klatek przy regulowanych prędkościach klatek od trzech do 30 klatek na sekundę.

We wczesnych oznakach swoich możliwości, Stability przeprowadziło badania preferencji użytkowników. Firma stwierdziła, że Video Diffusion było preferowane przez odbiorców, w porównaniu do konkurencyjnych modeli od Pika Labs i Runway do generowania wideo.

Można zapisać się na listę oczekujących na dostęp do nadchodzącej aplikacji z interfejsem tekst-na-wideo, który pokazuje praktyczne zastosowania Stable Video Diffusion w edukacji, marketingu i rozrywce. W formularzu kontaktowym wybierz “Stable Video – Waitlist” w rozwijanym menu.