Google Lumiere to model tekst-na-wideo, który wykorzystuje nową technikę do tworzenia realistycznych filmów z krótkich tekstów. Firma właśnie pokazała to rozwiązanie.

Lumiere tworzy filmy, które prezentują realistyczny ruch i mogą nawet wykorzystywać obrazy i inne filmy jako materiały wejściowe, aby poprawić wyniki. Zaprezentowany w pracy pt. “Model dyfuzji przestrzenno-czasowej do generowania wideo”, Google Lumiere działa inaczej niż istniejące modele do generowania filmów. Generuje czas trwania filmu na raz, podczas gdy istniejące modele syntezują odległe kluczowe klatki, a następnie dokonują czasowej super-rozdzielczości.

Mówiąc wprost, Lumiere skupia się na ruchu obiektów na obrazie, podczas gdy poprzednie systemy składają film z kluczowych klatek, w których ruch już się odbył.

Model Google’a jest zdolny do generowania filmów składających się z 80 klatek. Dla porównania, Stable Video Diffusion od Stability osiąga 14 i 25 klatek. Warto natomiast podkreślić, że im więcej klatek, tym płynniejszy ruch filmu.

Google Lumiere lepszy niż konkurencja

Lumiere przewyższa konkurencyjne modele generacji wideo od firm takich jak Pika, Meta i Runway w różnych testach, w tym próbach zero-shot.

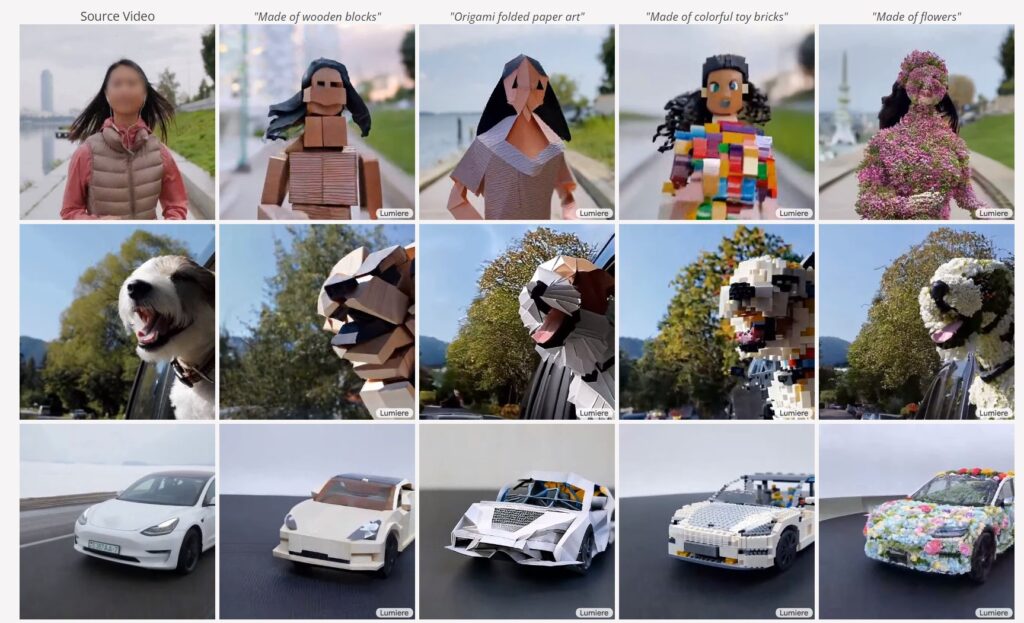

Naukowcy twierdzą także, że Lumiere produkuje najnowocześniejsze efekty jako rezultat swojego alternatywnego podejścia. Twierdzą, że wyjścia Lumiere mogą być używane w zadaniach tworzenia treści i edycji wideo, w tym w inpainting wideo i stylizowanej generacji (naśladowanie artystycznych stylów, które są pokazywane) poprzez użycie dostrojonych wag modelu tekst-na-obraz.

Aby osiągnąć swoje wyniki, Lumiere wykorzystuje nową architekturę, Space-Time U-Net. Generuje ona cały czas trwania filmu na raz, poprzez pojedyncze przejście w modelu.

Zespół Google’a napisał, że nowatorskie podejście poprawia spójność wyników:

Wykorzystując zarówno przestrzenne, jak i (co ważne) czasowe próbkowanie w dół i w górę oraz wykorzystując wytrenowany model dyfuzji tekst-na-obraz, nasz model uczy się bezpośrednio generować pełną prędkość klatek, niskiej rozdzielczości wideo, przetwarzając je w wielu skalach przestrzenno-czasowych

czytamy w pracy Google’a

Celem projektu Lumiere było stworzenie systemu umożliwiającego początkującym użytkownikom łatwiejsze tworzenie treści wideo.

W pracy technicznej Google’a pojawia się również informacja o tym, że istnieje ryzyko potencjalnego nadużycia. Eksperci ostrzegają, że modele takie jak Lumiere mogą być używane do tworzenia fałszywych lub szkodliwych treści. “Uważamy, że kluczowe jest rozwijanie i stosowanie narzędzi do wykrywania stronniczości i złośliwych przypadków użycia, aby zapewnić bezpieczne i sprawiedliwe wykorzystanie” — czytamy.

Google Lumiere. Na razie tylko pokazowo

Firma Google na razie nie udostępniła modelu publicznie. Możemy eksplorować różne przykłady generacji na stronie pokazowej na GitHubie.

Zobacz wideo dot. modelu Lumiere:

Premiera Lumiere następuje po VideoPoet, multimodalnym modelu wyprodukowanym przez Google, który tworzy filmy z tekstów, filmów i obrazów. Zaprezentowany w grudniu ubiegłego roku, VideoPoet wykorzystuje nieco inne rozwiązanie, sprawiając, że jest zdolny do tworzenia treści, na których nie był wcześniej szkolony.

Google opracował kilka modeli generacji wideo, w tym Phenaki i Imagen Video, a także planuje dodać opcję fimów AI do swoich narzędzi SynthID.

Prace Google’a nad wideo uzupełniają jego model bazowy Gemini, a w szczególności multimodalny punkt końcowy Pro Vision, który jest zdolny do obsługi obrazów i wideo jako wejścia oraz generowania tekstu jako wyjścia. ChatGPT nie może pochwalić się podobnymi możliwościami. Przynajmniej na razie.

Czytaj też: