Rozwój sztucznej inteligencji zmienia także medycynę. AI może pomagać w analizie wyników badań, usprawniać procesy diagnostyczne i wspierać lekarzy w podejmowaniu decyzji. Jednak korzystanie z chatbotów AI do konsultacji medycznych rodzi poważne pytania o bezpieczeństwo i odpowiedzialność. Mimo potencjalnych korzyści, istnieje wiele zagrożeń, a sytuacje takie jak te związane z chatbotem Grok na platformie X (dawniej Twitter) budzą kontrowersje.

Elon Musk entuzjastycznie o AI w diagnostyce medycznej. Wielkie ambicje czy nieodpowiedzialne ryzyko?

Elon Musk, znany z ambitnych projektów technologicznych, takich jak Neuralink czy xAI, otwarcie promuje wykorzystanie AI w analizie medycznej. Jego chatbot Grok miał umożliwić użytkownikom przesyłanie obrazów medycznych, takich jak RTG, MRI czy PET, aby AI mogła nauczyć się interpretować wyniki badań. Musk twierdzi, że Grok „już teraz działa całkiem dobrze” i z czasem stanie się „bardzo dobry”.

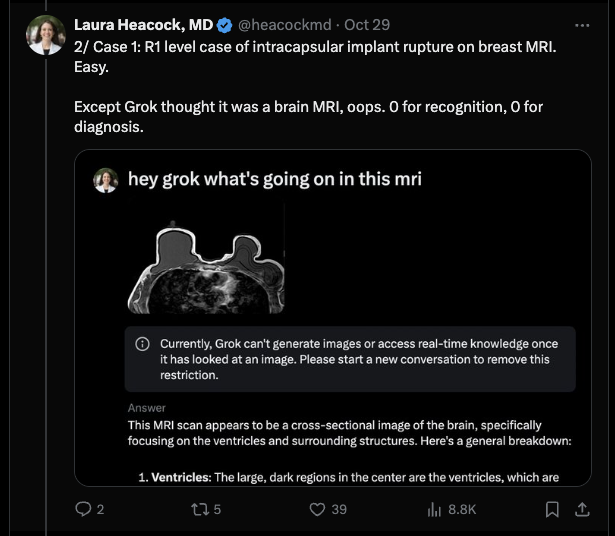

Jednak te optymistyczne zapowiedzi kontrastują z licznymi błędami, jakie Grok popełnił podczas analiz. Przykładowo, chatbot mylnie zinterpretował obraz mammograficzny, uznając łagodną cystę piersi za męskie narządy płciowe. W innym przypadku pomylił chorobę Potta (tzw. gruźlicę kręgosłupa) z przepukliną kręgosłupa (tj. z uszkodzeniem krążka międzykręgowego). Takie pomyłki nie tylko podważają wiarygodność AI, ale mogą też mieć tragiczne konsekwencje dla pacjentów.

1/ Challenge accepted. I have run a series of breast mammograms (x-rays), ultrasounds and MRIs through versions of GPT4 and posted the results here previously.

— Laura Heacock, MD (@heacockmd) October 29, 2024

Even though it's data contamination to repost images I already used on X, it's an easy bench mark.

So how did Grok do… https://t.co/DCqN5B73bB

Problemy z prywatnością – co się dzieje z naszymi danymi?

Jednym z największych problemów związanych z używaniem AI do celów medycznych jest kwestia ochrony danych. Musk zachęca użytkowników do przesyłania wyników badań, ale nie podaje jasnych informacji na temat tego, kto ma dostęp do tych danych i jak są one wykorzystywane. Dane wprowadzane do Groka mogą być wykorzystywane do dalszego szkolenia modelu AI, co oznacza, że teoretycznie mogą być przechowywane, analizowane i nawet udostępniane innym podmiotom.

Co więcej, dane medyczne przesyłane na platformy społeczne, takie jak X, nie są chronione przez amerykańskie przepisy o ochronie danych medycznych (HIPAA). Użytkownicy często nie są świadomi, że ich prywatne informacje mogą trafić w niepowołane ręce – od pracodawców, przez firmy ubezpieczeniowe, po instytucje rządowe.

Dlaczego AI w medycynie to pole minowe?

Rozwój AI w medycynie wymaga precyzji, odpowiedzialności i etycznego podejścia. Tymczasem Grok korzysta z danych użytkowników platformy X, a nie z bezpiecznych, anonimowych baz medycznych. Wyniki uzyskane w ten sposób nie są reprezentatywne dla całej populacji i mogą prowadzić do błędnych diagnoz. Ponadto, medyczne obrazy często zawierają dane identyfikujące pacjenta, co dodatkowo zwiększa ryzyko naruszenia prywatności.

Eksperci, tacy jak aktywna na X dr Laura Heacock z New York University Langone Health, wskazują, że obecne metody AI niezwiązane z generatywnymi modelami, takie jak systemy oparte na algorytmach uczenia maszynowego, znacznie lepiej radzą sobie z analizą obrazów medycznych. To pokazuje, że choć AI ma potencjał, droga do jego pełnego wykorzystania w medycynie jest długa.

Czy możemy zaufać chatbotom w kwestii zdrowia?

Konsultacje medyczne z chatbotami AI mogą być kuszące – szybkie odpowiedzi, brak kosztów wizyty u lekarza i możliwość uzyskania informacji w dowolnym momencie. Jednak ryzyko błędnych diagnoz, naruszenia prywatności i braku odpowiedzialności za skutki takich porad są poważnymi powodami, by zachować ostrożność. Nawet sam Musk przyznaje, że Grok jest na „wczesnym etapie rozwoju”, co stanowi wyraźne ostrzeżenie dla użytkowników.

Konsultowanie stanu zdrowia z chatbotami AI, choć nowoczesne i łatwe, niesie ze sobą liczne ryzyka. Bez względu na to, jak zaawansowana staje się technologia, decyzje dotyczące zdrowia powinny opierać się na konsultacjach z wykwalifikowanymi specjalistami. Warto pamiętać, że dane raz udostępnione w internecie mogą tam pozostać na zawsze. Dlatego, zanim zaufamy chatbotom AI w kwestiach medycznych, powinniśmy dokładnie rozważyć konsekwencje.

Czytaj dalej: